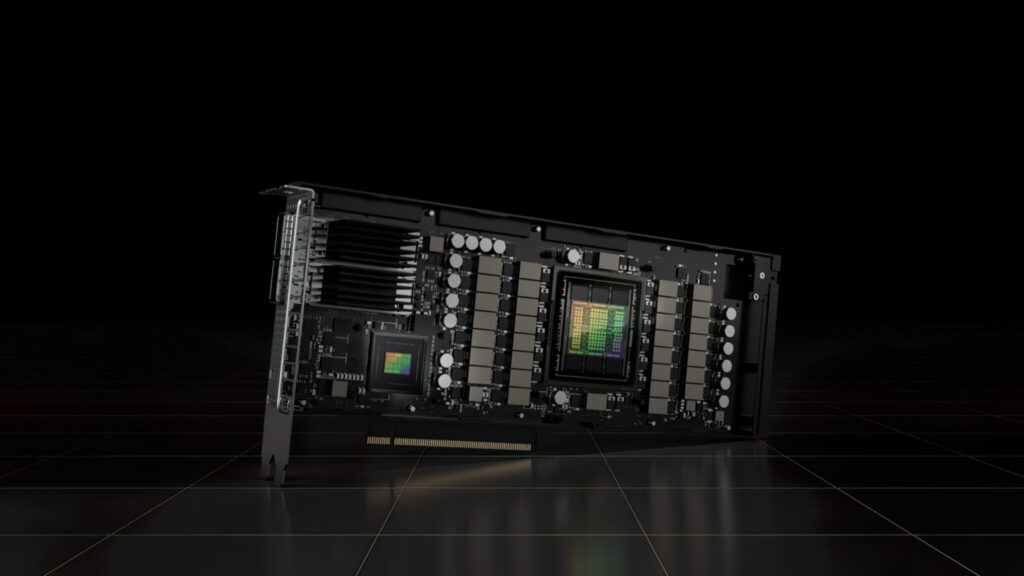

先日発表されたNVIDIAのHopper GPUアーキテクチャを採用した80GB PCIeアクセラレータ「H100」が、日本国内でも販売開始されることが明らかになった。

これは、数日前に掲載されたAMD MI210 PCIeに次いで、日本市場で価格とともに掲載された2つ目のアクセラレータです。

NVIDIA H100 80GB PCIe Accelerator with Hopper GPUが、3万ドルを超える非常識な価格で日本に出品されました。

H100 SXM5とは異なり、H100 PCIeはGH100 GPUの144 SM、H100 SXMの132 SMのうち、114 SMを有効化することで仕様を削減しているのが特徴。

このチップは、3200 FP8、1600 TF16、800 FP32、48 TFLOPsのFP64演算能力を備えています。

また、456個のTensor & Texture Unitsを備えています。

ピーク演算能力が低いため、H100 PCIeは低クロックで動作し、TDPはSXM5の2倍の700Wに対して350Wとなっています。

しかし、PCIeカードは、5120ビットのバスインターフェイスに80GBのメモリを搭載していますが、HBM2eのバリエーション(2TB/sを超える帯域幅)を維持しています。

gdm-or-jpによると、日本の流通会社gdep-co-jpが、NVIDIA H100 80GB PCIeアクセラレータを、価格¥4,313,000(US$33,120)、消費税込み総額¥4,745,950、US$36,445に換算して掲載しました。

この加速器は2022年後半に出荷される予定で、標準的なデュアルスロットのパッシブ冷却型が用意されます。

また、複数枚購入者には販売元がNVLINKブリッジを無償で提供するとされているが、後日出荷される可能性もある。

現在、同じ市場で約16,500ドルのAMD Instinct MI210と比較すると、NVIDIA H100は2倍以上の価格です。

NVIDIA の製品は、AMD の HPC アクセラレータに対して、50W 増の非常に高い GPU パフォーマンスの数値を誇っています。

H100 の非Tensor FP32 TFLOPs は 48 TFLOPs で、MI210 は 45.3 TFLOPs の FP32 計算能力をピークに定格されています。

スパースとTensorの演算では、H100は最大800TFLOPsのFP32演算能力を発揮します。

また、メモリ容量もMI210の64GBに対して、H100は80GBと大きくなっています。見たところ、NVIDIAはAI/ML機能を向上させるために、プレミアム価格を設定しているようです。

NVIDIA Ampere GA100 GPUベースのTesla A100のスペック:

| NVIDIA Tesla グラフィックス カード |

NVIDIA H100 (SMX5) | NVIDIA H100 (PCIe) | NVIDIA A100 (SXM4) | NVIDIA A100 (PCIe4) | Tesla V100S (PCIe) | Tesla V100 (SXM2) | Tesla P100 (SXM2) | Tesla P100 (PCI-Express) |

Tesla M40 (PCI-Express) |

Tesla K40 (PCI-Express) |

| GPU | GH100 (Hopper) | GH100 (Hopper) | GA100 (Ampere) | GA100 (Ampere) | GV100 (Volta) | GV100 (Volta) | GP100 (Pascal) | GP100 (Pascal) | GM200 (Maxwell) | GK110 (Kepler) |

| 製造プロセス | 4nm | 4nm | 7nm | 7nm | 12nm | 12nm | 16nm | 16nm | 28nm | 28nm |

| トランジスタ数 | 800億 | 800億 | 542億 | 542億 | 211億 | 211億 | 153億 | 153億 | 80億 | 71億 |

| GPUダイサイズ | 814mm2 | 814mm2 | 826mm2 | 826mm2 | 815mm2 | 815mm2 | 610 mm2 | 610 mm2 | 601 mm2 | 551 mm2 |

| SM数 | 132 | 114 | 108 | 108 | 80 | 80 | 56 | 56 | 24 | 15 |

| TPC数 | 66 | 57 | 54 | 54 | 40 | 40 | 28 | 28 | 24 | 15 |

| SM毎のFP32 CUDA コア数 |

128 | 128 | 64 | 64 | 64 | 64 | 64 | 64 | 128 | 192 |

| SM毎のFP64 CUDA コア数 |

128 | 128 | 32 | 32 | 32 | 32 | 32 | 32 | 4 | 64 |

| FP32 CUDA コア数 |

16,896 | 14,592 | 6,912 | 6,912 | 5,120 | 5,120 | 3,584 | 3,584 | 3,072 | 2,880 |

| FP64 CUDA コア数 |

16,896 | 14,592 | 3,456 | 3,456 | 2,560 | 2,560 | 1,792 | 1,792 | 96 | 960 |

| Tensor コア数 | 528 | 456 | 432 | 432 | 640 | 640 | N/A | N/A | N/A | N/A |

| テスクチャ ユニット数 |

528 | 456 | 432 | 432 | 320 | 320 | 224 | 224 | 192 | 240 |

| Boost Clock | TBD | TBD | 1410 MHz | 1410 MHz | 1601 MHz | 1530 MHz | 1480 MHz | 1329MHz | 1114 MHz | 875 MHz |

| TOPs (DNN/AI) | 2000 TOPs 4000 TOPs |

1600 TOPs 3200 TOPs |

1248 TOPs 2496 TOPs with Sparsity |

1248 TOPs 2496 TOPs with Sparsity |

130 TOPs | 125 TOPs | N/A | N/A | N/A | N/A |

| FP16演算性能 | 2000 TFLOPs | 1600 TFLOPs | 312 TFLOPs 624 TFLOPs with Sparsity |

312 TFLOPs 624 TFLOPs with Sparsity |

32.8 TFLOPs | 30.4 TFLOPs | 21.2 TFLOPs | 18.7 TFLOPs | N/A | N/A |

| FP32演算性能 | 1000 TFLOPs | 800 TFLOPs | 156 TFLOPs (19.5 TFLOPs standard) |

156 TFLOPs (19.5 TFLOPs standard) |

16.4 TFLOPs | 15.7 TFLOPs | 10.6 TFLOPs | 10.0 TFLOPs | 6.8 TFLOPs | 5.04 TFLOPs |

| FP64演算性能 | 60 TFLOPs | 48 TFLOPs | 19.5 TFLOPs (9.7 TFLOPs standard) |

19.5 TFLOPs (9.7 TFLOPs standard) |

8.2 TFLOPs | 7.80 TFLOPs | 5.30 TFLOPs | 4.7 TFLOPs | 0.2 TFLOPs | 1.68 TFLOPs |

| メモリインター フェイス |

5120-bit HBM3 | 5120-bit HBM2e | 6144-bit HBM2e | 6144-bit HBM2e | 4096-bit HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 384-bit GDDR5 | 384-bit GDDR5 |

| メモリ容量 | 最大80 GB HBM3 @ 3.0 Gbps |

最大80 GB HBM2e @ 2.0 Gbps |

最大40 GB HBM2 @ 1.6 TB/s 最大80 GB HBM2 @ 1.6 TB/s |

最大40 GB HBM2 @ 1.6 TB/s 最大80 GB HBM2 @ 1.6 TB/s |

16 GB HBM2 @ 1134 GB/s |

16 GB HBM2 @ 900 GB/s |

16 GB HBM2 @ 732 GB/s |

16 GB HBM2 @ 732 GB/s 12 GB HBM2 @ 549 GB/s |

24 GB GDDR5 @ 288 GB/s |

12 GB GDDR5 @ 288 GB/s |

| L2キャッシュ 容量 |

51200 KB | 51200 KB | 40960 KB | 40960 KB | 6144 KB | 6144 KB | 4096 KB | 4096 KB | 3072 KB | 1536 KB |

| TDP | 700W | 350W | 400W | 250W | 250W | 300W | 300W | 250W | 250W | 235W |

ソース:wccftech – NVIDIA H100 80 GB PCIe Accelerator With Hopper GPU Is Priced Over $30,000 US In Japan

解説:

Hopperがあたおか価格で登場。

nvidiaのHPC用GPU、Hopperが物凄い価格で登場。

私は高価なものには縁がありませんので、最初は475,000円かとおもっていたのですが、4,750,000円と言う価格であることに気が付いて驚きました。

Lexusのニューモデルなのかな?

まあ、HPC向けなので、我々のような貧乏ゲーマーが購入することは全く考慮に入っていないのでしょうが、それにしても高い。

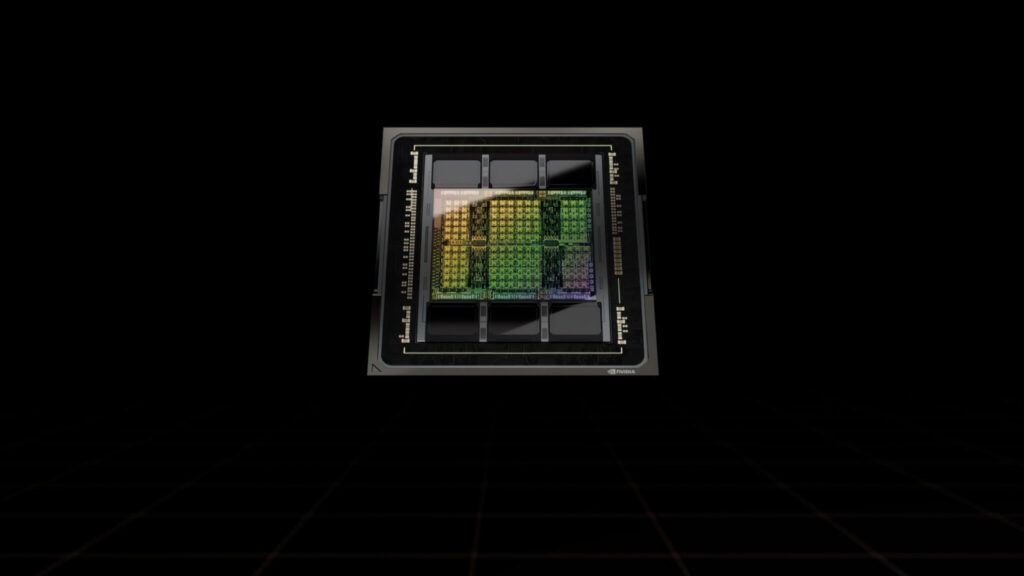

Hopperの最上位モデルGH100は1000mm2を超えるダイと言われています。

その上、世界最先端級のTSMC4nmですから、価格も高くなるのでしょう。

GH102だかGH101だかわかりませんが、AD102がRDNA3に負けた場合、どちらかがGeforceとして出るという噂がささやかれていましたが、続報がありませんのであれはやはり誤報だったのでしょうね。

nVidia RTX3000シリーズGPU

RTX3090

RTX3080Ti

RTX3080 10GB LHR

RTX3070Ti

Geforce RTX3070 8GB GDDR6 LHR

RTX3060Ti 8GB GDDR6

RTX3060 12GB GDDR6

RTX2000シリーズ

RTX2060 12GB

RTX2060が12GBメモリを搭載して復刻

nVidia Geforce RTX1600シリーズ

GTX1650SUPER

GTX1650 GDDR6

Copyright © 2022 自作ユーザーが解説するゲーミングPCガイド All Rights Reserved.

3070 Ti 搭載ビデオカード OC/ PCIe 4.0 / 8GB GDDR6X / HDMI 2.1 / DisplayPort 1.4a /デュアルボールファンベアリング, ミリタリーグレードのコンデンサ/ GPU Tweak II TUF-RTX3070TI-O8G-GAMING

3070 Ti 搭載ビデオカード OC/ PCIe 4.0 / 8GB GDDR6X / HDMI 2.1 / DisplayPort 1.4a /デュアルボールファンベアリング, ミリタリーグレードのコンデンサ/ GPU Tweak II TUF-RTX3070TI-O8G-GAMING