オーストラリアで最初の自動運転車の重大事故は、今年3月に発生しました。 歩行者は、次の場合に生命を脅かす怪我を負いました テスラモデル3に見舞われた、ドライバーは「自動操縦」モードであったと主張しています。

米国では、高速道路の安全規制当局が調査しています 一連の事故 オートパイロットのテスラが、交通停止中にライトが点滅しているファーストレスポンダーの車両に衝突した場所。

「自動運転」車の意思決定プロセスは、多くの場合、 不透明で予測不可能 (製造元に対しても)そのため、このようなインシデントの責任を誰が負うべきかを判断するのは難しい場合があります。 しかし、「説明可能なAI」の成長分野は、いくつかの答えを提供するのに役立つかもしれません。

自動運転車がクラッシュした場合、誰が責任を負いますか?

自動運転車は新しいものですが、それでもメーカーによって製造および販売されている機械です。 それらが害を及ぼす場合、製造業者(またはソフトウェア開発者)が安全上の責任を果たしているかどうかを尋ねる必要があります。

現代の過失法は有名な事件から来ています ドノヒューvスティーブンソン、女性がジンジャービールのボトルに分解するカタツムリを発見したところ。 カタツムリの行動を直接予測または制御することが期待されていたためではなく、瓶詰めプロセスが安全でなかったため、製造業者は過失を犯したことが判明しました。

この論理により、自動運転車のようなAIベースのシステムのメーカーや開発者は、「自律」システムが行うすべてのことを予測および制御できない可能性がありますが、リスクを軽減するための対策を講じることはできます。 彼らのリスク管理、テスト、監査、および監視の慣行が十分でない場合、彼らは責任を問われるべきです。

どのくらいのリスク管理で十分ですか?

難しい質問は、「どれだけの注意とどれだけのリスク管理で十分か」ということです。 複雑なソフトウェアでは、 すべてのバグをテストすることは不可能です あらかじめ。 開発者とメーカーは、いつ停止するかをどのように知るのでしょうか?

幸いなことに、裁判所、規制当局、および技術基準機関は、危険であるが有用な活動に対するケアと責任の基準を設定した経験があります。

欧州連合のように、基準は非常に厳格である可能性があります AI規制案、コストに関係なく「可能な限り」リスクを低減する必要があります。 あるいは、オーストラリアの過失法に似ているかもしれません。オーストラリアの過失法では、リスクの可能性が低い、または重大度が低い場合、またはリスク管理によってリスクのある活動の全体的な利益が減少する場合に、より厳格でない管理が許可されます。

訴訟はAIの不透明性によって複雑になります

リスクの明確な基準ができたら、それを実施する方法が必要です。 1つのアプローチは、ペナルティを課す権限を規制当局に与えることです(たとえば、ACCCが競争の場合に行うように)。

AIシステムによって被害を受けた個人も、訴えることができなければなりません。 自動運転車が関係する場合、メーカーに対する訴訟は特に重要になります。

ただし、このような訴訟を有効にするには、裁判所はAIシステムのプロセスと技術的パラメーターを詳細に理解する必要があります。

メーカーは、商業上の理由からそのような詳細を明らかにしないことを好むことがよくあります。 しかし、裁判所は、訴訟を容易にするために、商業的利益と適切な量の開示とのバランスを取るための手続きをすでに持っています。

AIシステム自体が不透明な場合、より大きな課題が発生する可能性があります。ブラックボックス」。 たとえば、テスラの自動操縦機能は「ディープニューラルネットワーク」、人気のあるタイプのAIシステムで、開発者でさえ、特定の結果に到達する方法や理由を完全に確信することはできません。

「説明可能なAI」が救いの手を差し伸べますか?

最新のAIシステムのブラックボックスを開くことが、 新着 波 コンピュータサイエンスと人文科学 学者:いわゆる「説明可能なAI」運動。

目標は、システムの構築方法を変更するか、事後に説明を生成することにより、開発者とエンドユーザーがAIシステムがどのように意思決定を行うかを理解できるようにすることです。

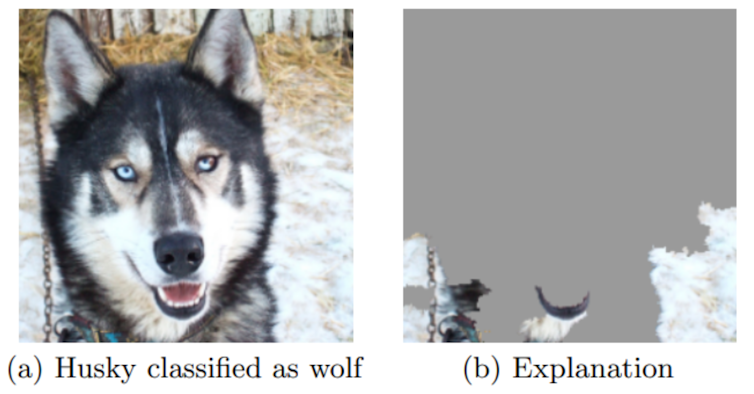

の 古典的な例、AIシステムは、ハスキーの写真を誤ってオオカミとして分類します。 「説明可能なAI」手法は、前景の動物ではなく、画像の背景の雪に焦点を合わせたシステムを明らかにします。

これが訴訟でどのように使用されるかは、特定のAIテクノロジーや引き起こされる害など、さまざまな要因によって異なります。 重要な懸念事項は、負傷者がAIシステムにどれだけアクセスできるかということです。

トリバゴ事件

私たちの 新しい研究 最近の重要なオーストラリアの訴訟を分析することで、これがどのように見えるかを垣間見ることができます。

2022年4月、連邦裁判所は、世界的なホテル予約会社Trivagoが、 競争ウォッチドッグACCC。 重要な質問は、Trivagoの複雑なランキングアルゴリズムがホテルの部屋のトップランクのオファーをどのように選択したかということでした。

連邦裁判所は、Trivagoの知的財産を保護するための保護手段を備えた証拠開示の規則を設定し、ACCCとTrivagoの両方が専門家の証人を呼び出して、TrivagoのAIシステムがどのように機能したかを説明する証拠を提供しました。

Trivagoのシステムへの完全なアクセスがなくても、ACCCの専門家証人は、システムの動作が顧客に「最良の価格」を与えるというTrivagoの主張と一致していないという説得力のある証拠を生み出すことができました。

これは、技術専門家と弁護士が一緒になって、訴訟でAIの不透明性を克服する方法を示しています。 ただし、このプロセスには緊密なコラボレーションと深い技術的専門知識が必要であり、費用がかかる可能性があります。

規制当局は、AI企業にシステムを適切に文書化するよう要求するなど、将来的に物事を合理化するための措置を講じることができます。

前方の道路

搭載車両 さまざまな程度の自動化 より一般的になり、完全に自律的なタクシーとバスの両方がテストされています オーストラリアで と 海外。

道路を可能な限り安全に保つには、AIと法律の専門家の間の緊密な協力が必要であり、規制当局、製造業者、保険会社、およびユーザーはすべて果たすべき役割を担います。![]()

この記事 アーロン・J・スノスウェル、ポスドク研究員、計算法とAIの説明責任、 クイーンズランド工科大学; ヘンリー・フレイザー、法学、説明責任およびデータサイエンスの研究員、 クイーンズランド工科大学、 と Rhyle Simcock、博士課程の候補者、 クイーンズランド工科大学 から再発行されます 会話 クリエイティブコモンズライセンスの下で。 読む 原著。

The post 自動運転車が衝突したときに裁判所が「説明可能なAI」を必要とする理由 appeared first on Gamingsym Japan.